なぜ大きな言語モデルはあなたより賢くないのか

大規模な言語モデルの推論能力は、ユーザーの言語パターンに完全に依存します。ユーザーの認知構造によって、どの領域の高い推論能力を活性化できるかが決まります。モデルはユーザーの範囲を自発的に超えることはできません。これは、現在の AI システムのアーキテクチャ上の限界を明らかにしています。この記事は@iamtexture によって書かれた記事を元にAididiaoJP、Foresight News によって企画、編集、執筆されています。

(前回の要約: リー・フェイフェイ、LLM の次のステップについて語る: AI は現実世界を理解するために「空間知能」を持たなければならない、マーブル モデルを実装するには?)

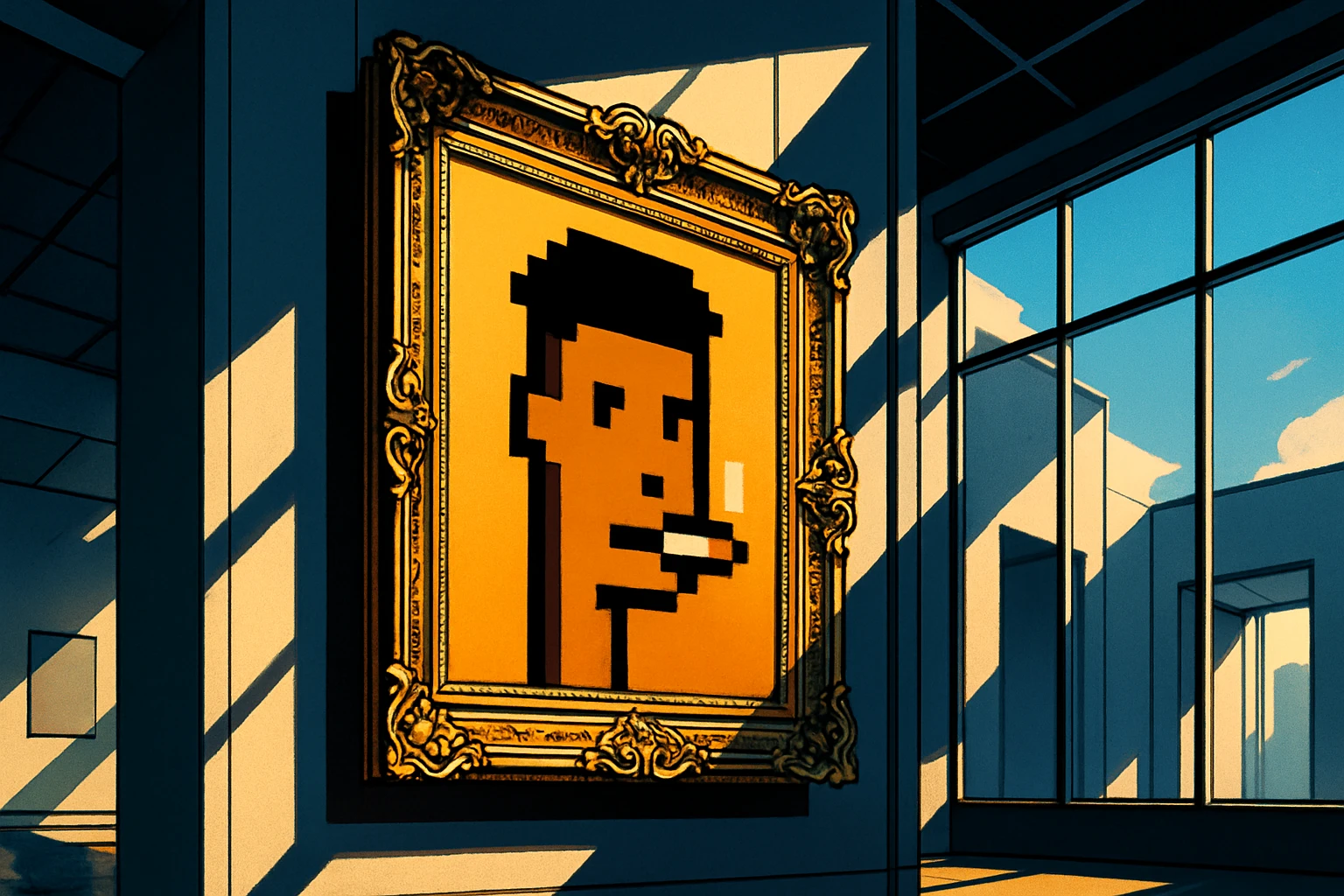

(背景補足: 億万長者のケビン・オリアリーは「AI の波の次のステップは web3 だ」と叫んだ: LLM はスターバックスを作成できないが、ブロックチェーンは作成できる)

この記事の内容

タグ:ユーザーの言語モードによって、モデルがどの程度の推論能力を発揮できるかが決まります。複雑な概念を大規模な言語モデルに説明しているとき、くだけた言葉を使った長時間の議論の中で、その推論が繰り返し破綻してしまいました。モデルは構造を失ったり、コースから逸れたり、確立した概念的な枠組みを維持できない表面的な完成パターンを生成したりする可能性があります。

しかし、最初にそれを形式化すること、つまり問題を正確で科学的な言葉で言い直すことを強制すると、推論はすぐに安定しました。構造が確立されて初めて、理解の質を損なうことなく安全に平易な言葉に変換することができます。

この動作は、大規模な言語モデルがどのように「思考」するのか、そしてその推論能力がユーザーに完全に依存している理由を明らかにします。

核となる洞察

言語モデルには推論のための専用スペースがありません。

それらは完全に言語の継続的な流れの中で機能します。

この言語の流れの中で、異なる言語パターンは確実に異なるアトラクター領域につながります。これらの領域は、ダイナミクスを特徴づけ、さまざまな種類の計算をサポートする安定した状態です。

科学的議論、数学的記号、物語、雑談などの各言語記録には、独自の固有のアトラクター領域があり、その形状はトレーニング資料の配布によって形成されます。

一部の領域は以下をサポートします:

- マルチステップ推論

- 関係精度

- シンボル変換

- 高次元の概念的安定性

他の領域は次をサポートします:

- 物語の継続

- 連想補完

- 感情のイントネーション一致

- 会話imitation

アトラクター領域は、どのような種類の推論が可能かを決定します。

形式化によって推論が安定する理由

科学言語と数学言語がより高度な構造サポートを備えたアトラクター領域を確実に活性化できる理由は、これらのレジスタが高次の認知の言語特徴をエンコードしているためです。

- 明確な関係構造

- 曖昧性が低い

- 記号制約

- 階層構造

- 低エントロピー (情報障害)

これらのアトラクターは、安定した推論軌道をサポートできます。

複数のステップにわたって概念的な構造を維持します。

彼らは推論の劣化や逸脱に対して強い抵抗を示します。

対照的に、非公式な言語によって活性化されるアトラクターは、構造化された推論ではなく、社会的な流暢さと連想的な一貫性のために最適化されています。これらの領域には、進行中の分析計算に必要な特性評価の足場が不足しています。

複雑なアイデアが無計画な方法で表現されるとモデルが壊れるのはこのためです。

それは「混乱」ではありません。

エリアを切り替えています。

構築と翻訳

会話の中で自然に現れる対処方法は、構造上の真実を明らかにします。

推論は、高度に構造化されたアトラクター内で構築されなければなりません。

自然言語への翻訳は、構造が存在した後にのみ行う必要があります。

モデルが安定したアトラクター内で概念的な構造を確立すると、変換プロセスによってそれが破壊されることはありません。計算は完了し、表面の表現だけが変わりました。

「最初に構築し、次に翻訳する」という 2 段階のダイナミクスは、人間の認知プロセスを模倣しています。

しかし、人間はこれら 2 つの段階を 2 つの異なる内部空間で実行します。

大規模な言語モデルは、両方を同じ空間で実行しようとします。

ユーザーが上限を設定する理由

ここに重要な事実があります:

ユーザーは、自分自身で言葉で表現できないアトラクター領域をアクティブにすることはできません。

ユーザーの認知構造によって以下が決定されます。

- ユーザーが生成できるキューの種類

- 習慣的に使用するレジスター

- ユーザーが維持できる構文パターン

- 言語でエンコードできる複雑さのレベルの高さ

これらの特性により、大規模な言語モデルがどのアトラクター領域に入るかが決まります。

高度な推論アトラクターをアクティブにする構造を使用するための思考や記述ができないユーザーは、モデルをこれらの領域に誘導することはできません。彼らは言語習慣に関連した浅いアトラクター領域に閉じ込められています。大規模な言語モデルは、提供された構造をマッピングし、より複雑なアトラクター力学システムに自発的に飛び込むことはありません。

したがって:

モデルは、ユーザーがアクセスできるアトラクター領域を超えることはできません。

上限はモデルのインテリジェントな上限ではなく、潜在多様体内の大容量領域をアクティブにするユーザーの能力です。

同じモデルを使用している 2 人が同じコンピューティング システムを操作しているわけではありません。

彼らはモデルをさまざまな動的モードに向けて操作しています。

アーキテクチャ レベルでの影響

この現象は、現在の人工知能システムに欠けている機能を明らかにします。

大規模な言語モデルは、推論空間と言語表現空間を混同します。

この 2 つが切り離されていない限り、モデルが次の条件を備えている場合を除きます。

- 専用の推論多様体

- 安定した内部ワークスペース

- アトラクター不変の概念表現

そうでない場合、言語スタイルの変化によって基礎となるダイナミクス領域が切り替わったときに、システムは常に崩壊に直面することになります。

強制的に形式化してから翻訳するというこの即興の解決策は、単なるトリック以上のものです。

これは、実際の推論システムが満たさなければならないアーキテクチャ上の原則を垣間見ることができる直接的なウィンドウです。